Irrtümer der Digitalfotografie (1)

Eines möchte ich vorweg nehmen: Das Thema Fotografie ist weit umfangreicher, als es den meisten Menschen bewusst ist. Dieser Artikel wird daher nicht versuchen, jedes Detail bis in die Tiefe zu erklären, vielmehr werde ich Irrtümer, Fehleinschätzungen und Vergleiche aufführen, um einige Verständnisprobleme aufzuzeigen. Ich möchte versuchen, den verschobenen Blickwinkel, den einige Menschen auf das gesamte Thema haben, zu korrigieren, sowie einige Sachverhalte erklären. Details und ausführliche Beschreibungen werden an anderer Stelle und zu einem späteren Zeitpunkt folgen.

Fotografieren ist schon lange ein beliebtes Hobby. Es zählt heute (2013) bereits zu den alltäglichen Dingen. Bis in die späten 1980er Jahre war das Fotografieren weit weniger weit verbreitet als heute. Erst durch preiswertere Kameras und Filme in den 1990er Jahren wurde zunehmend mehr fotografiert. Da Filme, Entwicklung und Abzüge noch immer relativ teuer waren, Fotografierte man nur bei den wichtigsten Ereignissen wie Feierlichkeiten oder im Urlaub. Das war noch die Zeit des chemischen Analogfilmes. Mit einer damals üblichen Kleinbild-Filmrolle konnten 24 oder 36 Aufnahmen erstellt werden. Aus heutiger Sicht wirklich nicht sehr viel. Man überlegte gut bevor man den Auslöser drückte. Doch mit der digitalen Revolution in der Fotografie um die Jahrtausendwende änderte sich dies schlagartig. Digitalkameras benötigen keine Filmrollen mehr sondern nutzen eine digitale Speicherkarte. Hunderte oder tausende Aufnahmen lassen sich so speichern und wieder löschen, ohne dass dies zusätzlich Geld kostet. Daher ist es heute üblich, „wild drauf los zu knipsen“. Später lässt sich aussortieren und entscheiden, welche Bilder man behalten möchte und welche man auf Papier bringen möchte. Die Kosten sind daher heute sehr überschaubar.

Mit dem erscheinen bezahlbarer Digitalkameras hat sich nicht nur die Anzahl der Hobbyfotografen explosionsartig erhöht, auch die Diskussion rund um die Fotografie hat enorm zugenommen. Das Web – respektive das Internet – haben dabei mitgeholfen, das Wissen rund um die Fotografie zu verteilen. Leider haben sich auch Halbwissen und allerlei Missverständnisse auf diese weise verbreitet und gemehrt. Heute finden sich tausende Webseiten mit identischen oder vergleichbaren Informationen. Leider ist einiges von dem was dort geschrieben steht fehlerhaft und führt beim interessierten Fotografie-Einsteiger sowohl zu Verwirrung als auch zu falschen Annahmen. Dies führt leider all zu oft dazu, dass Fotografiebegeisterte unnötigerweise Geld für Equipment ausgeben, welches sie eigentlich nicht benötigen. Ebenso wird wiederholt in Foren gestritten, ohne dass dies irgendeinen Sinn ergeben würde und ohne, dass am Ende für die Gemeinschaft etwas nützliches dabei heraus kommt.

Im folgenden möchte ich einige Aussagen und Themen angehen, die meines Erachtens stark fehlgeleitet sind.

Behauptung 1: Mehr Pixel sind immer besser

Digitalkameras arbeiten mit digitalen Bildsensoren die ein Bild mithilfe einer Vielzahl lichtempfindlicher Zellen erfassen. Die lichtempfindlichen Zellen sind dabei gleichmäßig auf der Fläche des Bildsensors verteilt. Im Allgemeinen spricht man hier von „Pixeln“ (Abk. für Picture Element). Die Hersteller haben über die Jahre dafür gesorgt, dass neue Kameramodelle mit immer höheren Pixelauflösungen auf den Markt kommen. In der Anfangszeit gab es Kameras mit 1-2 Megapixeln (also 1-2 Millionen Pixeln), doch es wurden schnell mehr. Inzwischen (stand 2013) besitzen Kompakt-Kameras im Schnitt zwischen 10 und 14 Megapixeln. Hochwertigere Kamerasysteme – beispielsweise digitale Spiegelreflexkameras – besitzen durchaus auch höhere Pixelauflösungen von über 20 Megapixeln. Die Hersteller haben dem Kunden mit immer höher werdenden Pixelauflösungen versprochen, dass damit immer bessere und schärfere Aufnahmen gelingen. Leider ist dies nur die halbe Wahrheit und größtenteils nur eine Marketingstrategie.

Je mehr Pixel auf der gleichen Sensorfläche untergebracht werden müssen, desto mehr Probleme ergeben sich daraus. Die Pixel werden mit steigender Zahl immer kleiner und können somit weniger Licht aufnehmen, was – aus verschiedenen Gründen – die Bildqualität deutlich mindert. Aus technischer Sicht gibt es daher ein „gesundes Maß“ für die Pixelgröße. Da aus Kostengründen in den Kompaktkameras (und auch in Mobiltelefonen und Smartphones) die Sensorfläche sehr klein gehalten wird, stößt man schnell an die Grenzen des Sinnvollen. Die winzigen Bildsensoren vertragen durchaus 4-6 Megapixel, doch anschließend wird es – buchstäblich – eng. Auf dem folgenden symbolischen Bild kann man einen Eindruck davon gewinnen, wie dicht die einzelnen Bildpunkte gepackt werden müssen, wenn der Bildsensor kleiner und kleiner wird. Während Kleinbildsensoren und gängige APS-C-Sensoren von Spiegelreflexkameras Großflächige Sensoren besitzen, sind diese in gängigen Kompaktkameras wahre Winzlinge. Die gleiche Menge lichtempfindlicher Zellen muss hier auf sehr viel kleinerer Fläche platz finden. Oder aber es werden – bei großen hochauflösenden Sensoren – zu viele Zellen untergebracht. Relevant ist hier immer die Größe des einzelnen Pixel.

Die Hersteller müssen aufgrund der hohen Pixeldichte mit Tricks und technischen kniffen arbeiten, um das ausgegebene Bild gut aussehen zu lassen. Man könnte sich diese Tricks jedoch sparen, würde man es mit der Pixelmenge nicht übertreiben. Dies würde der Bildqualität zugute kommen und auch dem Geldbeutel gut tun. Doch der Kunde will mehr, immer mehr und glaubt, es würde ihm und den Fotografien gut tun.

Ein Großteil der Kunden ist durch die blendende Werbung der Hersteller inzwischen so stark auf „mehr ist besser“ konditioniert, dass nicht weiter nach dem Sinn gefragt oder darüber nachgedacht wird. Tatsächlich ist der Nutzen des Megapixel-Wahns für die meisten Kunden eher fraglich. Für rund 90% der Käufer (persönliche Annahme) genügen 6-8 Megapixel vollkommen. Diejenigen, die höhere Pixelauflösungen tatsächlich sinnvoll nutzen können benötigen ohnehin ein hochwertigeres Kamerasystem wie eine digitale Spiegelreflex- oder andere Systemkamera. Diese besitzen dann auch eine weitaus größere Sensorfläche und vertragen somit deutlich mehr.

Doch warum benötigt man angeblich „nur“ 6-8 Megapixel? Versuchen wir dies einmal näher zu betrachten: Die Zahl der Megapixel alleine sagt nichts darüber aus, wie scharf oder wie detailreich eine Fotografie wird. Dies hängt von sehr viel mehr ab als nur von der Sensorauflösung. Insbesondere die verwendete Optik, also das Objektiv mit seinen Linsen, ist hier für die Bildqualität maßgeblich. Der Sensor selbst kann nur erfassen, was ihm die optischen Elemente liefern. Viele Standardobjektive erreichen nicht die Abbildungsleistung, um hochauflösende Sensoren mit ausreichend Details zu versorgen. Ein unscharfes Bild von einer mittelmäßigen Optik, kann auch der hochauflösenste Sensor nicht besser erfassen als ein Sensor, der gerade das zur Optik passende Auflösungsvermögen besitzt. Mehr Megapixel würden daher keinen Sinn machen und lediglich unnötig große Datenmengen erzeugen. Die verwendete Optik und der Bildsensor müssen also zueinander passen, was oft nicht der Fall ist.

Doch ganz unabhängig von der Qualitätsfrage der Aufnahme selbst stellt sich die Frage: „Was macht der Hobbyfotograf mit den Bildern?“ Während man früher Bildabzüge vom Fotolabor bekam, schaut man sich die Fotos heute eher am Bildschirm an. Auch heutzutage lassen sich noch einige Menschen Bildabzüge erstellen oder drucken auch mal ein Foto selbst aus. Aber genau hier wird es interessant, denn für diese Zwecke benötigt man keine extrem hohen Pixelauflösungen. Ein Full-HD Display oder TV-Gerät kann rund 2 Megapixel darstellen. Selten findet man in Haushalten Displays mit höheren Auflösungen (Stand 2013). Einen Bildabzug aus dem Fotolabor im Format 9 x 13 cm kann rund 3 Megapixel darstellen und ein Bildabzug auf DIN A4 Größe knapp 8 Megapixel. Auch Ausdrucke auf dem heimischen Tintenstrahldrucker benötigen nicht mehr. Eine Bilddatei mit z.B. 18 Megapixeln würde auf dem 9 x 13 cm Bildabzug nicht besser aussehen, als eine mit der gleichen Optik aufgenommene 2 Megapixel-Datei. Die Fotolabore oder auch der heimische Drucker drucken die Bilder mit einer Auflösung von 300-400 ppi. Basierend darauf sind die Auflösungen berechnet.

Info: Die Einheit ppi darf nicht mit der Angabe dpi bei Tintenstrahldruckern verwechselt werden. Tintenstrahldrucker setzen einen farbigen Vollfarbpunkt aus mehreren Druckfarbpunkten zusammen. Die Angabe dpi kann als näherungswert bei Tintenstrahldruckern in etwa durch 8 geteilt werden, um auf die maximal möglichen ppi zu kommen.

Wer vor hat, seine Fotos als Poster drucken zu lassen, könnte behaupten, dass er deutlich höhere Auflösungen benötigt. Immerhin ist so ein 60 x 80 cm Poster schon eine ganz andere Größenordnung. Würde man hier mit 400 ppi drucken, so dass jedes Pixel der Kamera einem Druckpunkt entspräche, benötigten wir eine Bilddatei mit rund 12600 x 9500 Pixeln, was knapp 120 Megapixel ergibt! Dass das kaum realistisch ist, merkt man sofort. Doch keine Sorge, auch ein qualitativ gutes Foto von einer 8 Megapixel-Kamera kann durchaus auf diese Größe gedruckt werden. Man muss hierbei die Auflösung unseres Auges und den Betrachtungsabstand mit einberechnen. Kleine Bilder mit 300-400 ppi sind für einen Betrachtungsabstand bis 30 cm gedacht. Je weiter wir uns von dem Bild entfernen, desto weniger Details kann unser Auge erfassen. Das bedeutet, dass die nötige Druckauflösung geringer wird, je größer der Betrachungsabstand ist. Ein Poster wird üblicherweise aus etwa 1-2 Meter Entfernung betrachtet. Hierfür genügt daher eine deutlich geringere Auflösung mit etwa 45 – 88 ppi. Bei 88 ppi läge die nötige Auflösung für einen 80 x 60 cm Druck bei rechnerisch 5,6 Megapixel. Großformatige Bilder mit extrem hohen Auflösungen sind eher etwas für Kunstdrucke oder Spezialanfertigungen, aber kaum etwas für den Privatnutzer. Außer natürlich sie betrachten sich ihr 60 x 80 cm Poster immer aus 30 cm Entfernung.

Behauptung 2: Mehr Megapixel = schärferes Bild

Wie bereits geschrieben gehen die meisten Menschen davon aus, dass Bildschärfe etwas mit der Auflösung zu tun hat. Dies ist selbstverständlich nicht ganz falsch, doch ist es irreführend. Man muss hierbei den Unterschied zwischen den Begriffen „Auflösung“ und „Bildschärfe“ verstehen. Zwar gibt es einen Zusammenhang zwischen den beiden Begriffen, doch müssen die Abhängigkeiten hier genau verstanden werden. Um zu verstehen, was Bildschärfe und Auflösung genau bedeuten, muss man zuerst verstehen, was Bildschärfe für unsere Wahrnehmung bedeutet.

Eine hohe Auflösung ist durchaus wünschenswert wenn feine Details abgebildet werden sollen. Doch auch ein unscharfes Bild kann mit einer hohen Auflösung dargestellt werden, ist dann aber noch immer unscharf. Damit ein Bild für uns scharf wirkt, kommt es vor allem auf die Kontraste an. Je höher der Kontrast, desto schärfer wirkt ein Bild auf uns. Dies ist jedoch noch keine Bildschärfe in direkten Sinn. Grob zusammengefasst besteht ein Bild aus einer ansammlung von Farbverläufen und Helligkeitsübergängen. Der Wechsel zwischen einem Weißen zu einem Schwarzen Pixel eines Digitalfotos stellt hierbei den maximalen Kontrast dar, während der Wechsel von 75% auf 25% Helligkeit einen geringeren Kontrast bedeutet. Fotografieren wir beispielsweise einen dunklen Ast vor einem hellen Himmel, so haben wir hier eine Kante, die wir möglichst kontrastreich erfassen möchten. Wird das Motiv jedoch unscharf fotografiert, bekommen wir einen weichen Verlauf über einige Pixel der Bilddatei. Somit reduziert sich der lokale Kontrast (Ortsfrequenz) und das Bild wirkt unscharf. Ob in diesem Fall eine hohe oder eine niedrige Sensorauflösung vorhanden ist, spielt zunächst keine Rolle. Der lokale Kontrast – auch Mikrokontrast genannt – ist also ein wichtiger Faktor für die Bildschärfe.

Der allgemeine Kontrast des Bildes spielt ebenfalls eine wichtige Rolle. Ein Bild im Dunst oder Nebel aufgenommen wirkt flau und verwaschen. Dies liegt an der Streuung des Lichtes durch die Wassertröpfchen in der Luft. Auch in der Optik der Kamera kann es zu streuungseffekten kommen, vor allem bei Aufnahmen mit bestimmten Blendenöffnungen. Hier wird durch die Streuung der Gesamtkontrast des Bildes reduziert. So kann es vorkommen, dass ein Bild flau aufgenommen wird. Solch eine Fotografie wirkt auf den Betrachter ebenfalls weniger scharf, als eine Aufnahme mit höherem Kontrast.

Ein weiterer Faktor ist die Farbsättigung. Unsere Wahrnehmung (also unser Gehirn) geht davon aus, dass bei klarer Sicht und ausreichendem Licht, die Farben sehr kräftig sind, während die Farben bei feuchter Luft (Dunst, Nebel) verwaschen und flach sind. Besitzt ein Bild daher kräftige Farben, geht unser Gehirn davon aus, dass das Bild scharf ist. Dies ist eine Täuschung, besser gesagt, ein Effekt der psychologischen Eigenschaften unserer Wahrnehmung. Kamerahersteller, Fotolabore oder auch TV-Gerätehersteller machen sich diese Tatsache zunutze, indem sie die Bildfarben übernatürlich anheben, um so ein „knackigeres“ und „schärfer“ wirkendes Bild zu erzeugen. Leider hat das mit der Realität nicht viel zu tun und mit realer Detailschärfe schon gar nicht. Auf diesem Weg kann lediglich die Wahrnehmung manipuliert werden. In der Fotografie ist es jedoch wünschenswert, reale Details in der Aufnahme zu besitzen. Es geht dabei um die sogenannte „Informationsdichte“. Was wir mit dem Kamerasystem nicht erfassen, können wir später nicht hineinrechnen.

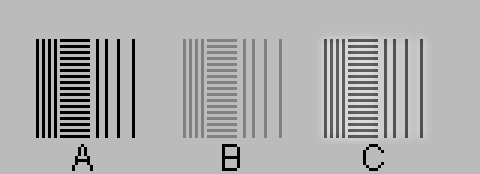

Ein weiterer Trick den Schärfeeindruck zu erhöhen ist das Nachschärfen. In der digitalen Bildverarbeitung geschieht dies oft durch einsetzen einer sogenannten „Unscharfmaskierung“. Hinter dem Begriff verbirgt sich ein Verfahren, welches die lokalen Kontraste künstlich anhebt. Hierzu werden im Bild die Konturen gesucht und anschließend deren Helligkeit so verändert, dass der lokale Kontrast für den Betrachter höher wirkt, als er ursprünglich war. Hier wid der Umstand ausgenutzt, dass unser Gehirn lokal begrenzte Helligkeitsunterschiede in einigen Situationen nicht mehr als solche erkennt. Durch diese lokale Kontrastanhebung stigt die wahrgenommene Kantenschärfe und das Bild wirkt schärfer. Leider werden hierbei aber Bildinformationen verfälscht, so dass sie mit der Realität nichts mehr gemein haben. Streng genommen gehen hierbei sogar Detailinformationen verloren. Nach Anwendung einer solchen Nachschärfung wirkt das Bild zwar schärfer, hat jedoch an Gesamtqualität verloren. Im folgenden Bild 1 sehen sie drei Linienstrukturen. Struktur A besitzt einen hohen Kontrast und ist maximal scharf. Struktur B ist die gleiche Struktur, jedoch mit geringerem Kontrast. Bei Struktur C wurde die Struktur B durch eine digitale Unscharfmaskierung nachgeschärft. B und C unterscheiden sich optisch in ihrer Schärfewirkung. C erscheint schärfer als B.

In Bild 2 sehen sie das identische Bild nochmals in einer Vergrößerung. Im nachgeschärften Element C kann man erkennen, dass um die eigentliche Linienstruktur, ein heller Halo liegt. Hier wurde also die Bildinformation um die Konturen herum verändert. Ebenso sind die Linien selbst dunkler geworden. Wir sehen also, dass hier eigentlich nicht die Schärfe verändert wurde, sondern durch das hinzufügen und verändern von Hellingkeitswerten um die Konturen die Wahrnehmung beeinflusst wurde.

Wenn wir diese Unscharfmaskierung auf reale Fotografien anwenden, dann muss uns immer bewusst sein, dass wir dabei nicht die Schärfe, sondern lediglich die Schärfewirkung beeinflussen. Gleichzeitig werden jedoch feine Farb- und Helligkeitsverläufe, sowie andere Bildinformationen, verändert und sogar zerstört – vor allem feine Farbverläufe. Im folgenden Bild 3 sieht man die Fotografie einer modellierten Figur in drei Ausführungen. Links das unbearbeitete Bild, in der Mitte mit einer leichten Unscharfmaskierung und rechts mit einer stark übertriebenen Unscharfmaskierung. Das mittlere Bild wirkt weitestgehend natürlich und im Vergleich zum linken Original etwas schärfer. Das rechte Bild hingegen wirkt verfremdet und unnatürlich, obwohl es dabei noch schärfer wirkt, als die anderen beiden. Doch ist hier deutlich zu erkennen, dass die Bildqualität durch die starke Unscharfmaskierung gelitten hat.

Wenn man sich die Augen der Figur ansieht stellt man fest, dass diese mit steigender Unscharfmaskierung dunkler werden. Ebenso werden auch andere Konturen immer Kontrastreicher (härter). Weiche Verläufe und feine Farbnuancen gehen zunemend verloren. Die Bildinformation wird verfremdet und entfernt sich immer weiter von einer natürlichen darstellung. Eine Nachschärfung auf diese Weise muss daher mit Bedacht gewählt werden und ist – soweit die Fotografie unter guten Bedingungen entstanden ist – eigentlich unnötig.

Nun noch einmal zurück zur eigentlichen Aussage „Mehr Megapixel = Schärfer“: Die Bildschärfe hängt in erster Linie davon ab, wie präzise das einfallende Licht des Motivs von dem Bildsensor erfasst werden kann. Durch zahlreiche Störfaktoren wird das Licht verändert wodurch Detailinformationen verloren gehen. Je besser die Bedingungen sind desto höher die Chance das Motiv scharf auf dem Bildsensor abzubilden. Jedes Kamerasystem hat hierbei seine speziellen Grenzen. Ist die verwendete Kameraoptik in der Lage unter Optimalbedingungen eine Pixelauflösung von umgerechnet 10 Megapixeln zu erreichen so macht auch nur ein entsprechender Bildsensor mit 10 Megapixeln Sinn (respektive 12-13 Megapixel, um Sensorbezogene ungenauigkeiten auszugleichen). Besäße der Sensor eine noch höhere Pixeldichte, beispielsweise 18, 24 oder mehr Megapixel, so würden wir lediglich die unschärfen der Optik mit in der Bilddatei speichern. Mit dieser gespeicherten Unschärfe können wir jedoch nichts anfangen, sie ist sogar unerwünscht. Um ein solches Bild anschließend wieder scharf wirken zu lassen, müssten wir die Pixelauflösung nachträglich wieder auf die 10 Megapixel reduzieren, oder aber mit unnützen Tricks arbeiten, ohne jedoch die tatsächliche Aufläsung verbessern zu können. Mit mehr Megapixeln bekämen wir hier also kein schärferes Bild, dafür jedoch eine unnötig große Bilddatei.

Im folgenden Bild möchte ich zeigen, dass die Pixelauflösung und die Informationsdichte einer Fotografie zwei unabhängige Parameter darstellen. Das Bild zeigt drei mal den gleichen Bildausschnitt einer Fotografie. Die Aufnahme wurde mit einem 18 Megapixel APS-C-Sensor und einem qualitativ durchschnittlichen Objektiv erstellt. Hierbei ist das Objektiv das begrenzende Element, denn der Bildsensor kann durchaus mehr Informationen erfassen, als das Objektiv ihm liefert.

Wie sie in Bild 4 erkennen, sind die beiden ersten Darstellungen (links und mittig) nahezu identisch. Es ist zunächst kaum ein Unterschied festzustellen. Die rechte Darstellung hingegen wirkt deutlich verwaschener und unscharf. Doch was sehen wir genau? Links sehen wir den Originalausschnitt, wie er von der Kamera erstellt wurde. Durch die Unschärfe des Objektivs, ist keine harte Kante an den schwarzen Linien zu erkennen. Der Übergang von Schwarz nach braun erfolgt in einem kurzen, aber weichen Verlauf. Die mittlere Darstellung zeigt den selben Ausschnitt, jedoch wurde dieser von den ursprünglichen 18 Megapixeln auf 6 Megapixel herunter gerechnet und anschließend für die Darstellung wieder auf die gleiche Größe wie das Original skaliert. Obwohl bei diesem Prozess eine ganze Menge an Pixeln verloren gegangen sind, sehen wir so gut wie keinen Unterschied zum Original. Hier erkennen wir deutlich, dass die Originaldatei zwar eine Pixelauflösung von 18 MPx besitzt, jedoch eine deutlich gerinere Informationsdichte. Eine Reduktion der Daten auf 6 MPx hat somit kaum Auswirkungen auf die wahrnehmbare Qualität der eigentlichen Fotografie. Die rechte Darstellung hingegen wurde auf 25% der originalauflösung (etwas mehr als 1 Megapixel) reduziert und anschließend wieder auf die Originalgröße Skaliert. Erst hier werden die Verluste der Bildinformation sichtbar, denn es wirkt unschärfer, als die beiden vorigen Darstellungen.

Wer ein Bild im Großformat drucken oder einen Bildausschnitt vergrößern möchte, der würde wahrscheinlich weiterhin behaupten, dass mehr Pixel besser sind als weniger. Natürlich gilt dies, solange auch nutzbare Informationen darin enthalten sind. Wie wir in Bild 4 sehen konnten, sagt die Anzahl der Pixel jedoch nichts über die Schärfe aus. Ob ein Bild zur Vergrößerung taugt, hängt davon ab, wie hoch die Kantenschärfe und der Mikrokontrast sind. Bei ausreichend hohem Mikrokontrast lassen sich auch Bilder mit geringerer Pixelauflösung annehmbar vergrößern. Ist der Mikrokontrast jedoch gering, hilft auch ein Megapixelmonster nichts.

Fazit: Mehr Pixel sind dann sinnvoll, wenn man sie auch mit sinnvoller Information füllen kann. Die wenigsten Menschen benötigen für ihre Urlaubs und Familien-Fotos wirklich hohe Auflösungen, da diese üblicherweise nur im Kleinformat oder am Bildschirm betrachtet werden. Hohe Pixeldichten schaden der Bildqualität bei kleinen Bildsensoren eher, als dass sie etwas nützen. Nur im professionellen Bereich gibt es durchaus Situationen, in denen Kamerasysteme mit sehr hohen Pixelauflösungen angebracht sind. Diese sind dann aber auch mit sehr hochwertiger Optik ausgestattet und kosten durchaus mal so viel wie ein Klein- oder auch Mittelklassewagen. Vernunft ist hier das Maß der Dinge. Wer gute Fotos für den Hausgebrauch erstellen will, investiert besser in gute optische Eigenschaften des Objektivs, als in übertriebene Sensorauflösungen. Wer die Zusammenhänge kennt, kann sich unnötige Ausgaben, Zeit und Frust ersparen.

Ich hoffe, hiermit zumindest einen Anreiz zum Nachdenken gegeben zu haben. Es ist jedoch nur die Spitze des Eisberges. Es gibt noch zahlreiche weitere Irrtümer und Themen, die ich in einem folgenden Beitrag weiter beschreiben werde. Bis dahin, viel Freude bei Fotografieren 🙂