PC-Bau mit Intel Core i9 9900K (Frühjahr 2019)

Nachdem mein alter PC (Baujahr Ende 2009) in die Jahre gekommen war – obgleich er seinen Zweck noch immer voll erfüllte – gab es doch gute Gründe sich um Planung und Bau eines neuen PC zu kümmern. Nicht zuletzt, da dieser noch auf Windows 7 lief und das Supportende im Januar 2020 nahte. Da dieses Projekt für den einen oder anderen PC-Bauer interessant sein könnte, habe ich mich für eine „ausführlichere“ Dokumentation des Ganzen Projektes hier in meinem Blog entschieden. Auch hinsichtlich der Probleme die mir im Projektverlauf begegneten.

Eines vorweg; meine ursprüngliche Planung sowie ein Budget von 1500 € habe ich sehr schnell verworfen. Das Gesamtprojekt kostete mich final rund 2600 € und das Ergebnis lag dann weit oberhalb dessen, was ich ursprünglich an Leistung eingeplant hatte.

Ich bitte auch gleich um Entschuldigung, dass ich einige Teile langatmig… sagen wir, „ausführlicher“ beschrieben habe. Nebendetails habe ich der Übersichtlichkeit halber in zusätzlich aufklappbare Infokästen verlegt. Ich hoffe, dass es nicht zu ermüdend wird und ausreichend „Unterhaltungswert“ beinhaltet. Zwar ließe sich fraglos noch unendlich detaillierter über das warum und wieso meiner Überlegungen berichten oder wie die Technologie im Detail von mir ausgewählt wurde, doch dann würde das hier keiner mehr lesen wollen. Allen Interessierten wünsche ich daher viel Freude – und Durchhaltevermögen.

Und noch eine Anmerkung die mir wichtig ist. Selbstredent hat jeder eine andere Auffassung dessen, was wichtig und richtig ist. Jeder – auch ich selbst – lebt in einer eigens kreierten Überzeugung zu Technologien und Komponenten. Daher kann auch ich lediglich meine Sichtweise hier representieren. Meine inzwischen rund 25 Jahre Erfahrung mit der PC-Plattform, zahllosen gebauten PCs und nicht zuletzt mein tiefes technisches Verständnis geben mir jedoch eine gute und stabile Grundlage. Es ist auch vollkommen in Ordnung wenn jemand ganz anderer Meinung als ich ist und gleichermaßen bin auch ich nicht frei von irrtümern. Insgesamt denke ich jedoch, dass ich mich recht nahe an dem bewege, was Sinnvoll und plausibel ist.

Die Hardwarelandschaft zum Jahreswechsel 2018/2019

Der Markt für PC-Komponenten hat sich in den letzten 10 Jahren (seit ich meinen letzten PC für mich gebaut habe) deutlich gewandelt. Die von mir früher gerne verwendeten Mainboards der oberen Konsumerklasse sind vom Markt weitestgehend verschwunden. Während es früher eine Aufteilung in die Gruppen „Preiswert“, Mittleres Segment“, „Oberes Segment“, „Gaming“ und „Workstation“ gab, schrumpfte dies über die Jahre zusammen. Das Preiswerte und mittlere Segment sind für meine Vorhaben weiterhin keine gute Wahl. Das einstige obere Segment gibt es aus meiner Sicht nicht mehr. Hier blieb mir nur das Gaming-Segment als Option. Die Workstation-Mainboards kämen durchaus in Frage, doch hier müsste man auf eine andere CPU-Architektur (z.B. Intel Xeon) zurückgreifen und dies würde die Kosten deutlich nach oben treiben. Die Leistung solcher Plattformen wäre nett, für mich aber ein Quäntchen zu viel des Guten. Somit begab ich mich – zwangsläufig – in die Gefilde der („dramatische Musik“) Gamer und Overclocker.

Bei den Grafikkarten musste ich ebenso umdenken. Wo mir früher eine GPU aus dem unteren Mittelfeld genügte, sind die Anforderungen der von mir eingesetzten Software inzwischen gänzlich andere. Auch hier musste ich nun in den Olymp der Gaming-Grafikkarten aufsteigen – was erneut zulasten des Budgets ging.

Beim Massenspeicher (Sprich „Festplatte“) betrieb ich bislang ein Mischsystem aus SSDs und HDDs. Der neue PC sollte nur noch mit SSDs ausgestattet werden. HDDs blieben noch als Archivmedien. Dazu ausreichend Arbeitsspeicher (RAM), ansonsten „nur das Nötigste“. Doch auch hier hat sich einiges getan und das ein oder andere klassische Denkmodell möchte gerne in Rente gehen. Man muss ja mit der Zeit gehen… mal abgesehen von den liebgewonnenen Retro-Geräten.

Der Plan

Zunächst stand die Frage im Raum: „Was möchte ich mit dem neuen Rechner alles machen können?“ Bisher lag mein Schwerpunkt im Bereich Videoschnitt, Grafikbearbeitung und Audio-Editing. Das ein oder andere Spiel sollte auch laufen (hier hatte ich nur geringe Ansprüche). Darüber hinaus sollten die Daten wie bisher redundant gespeichert werden, also gespiegelt im RAID1-Verbund. Hier gehe ich gerne auf Nummer Sicher und schütze mich vor dem Ausfall eines Einzelmediums. Das hat im Fehlerfall den Vorteil, dass ich einfach weiterarbeiten kann (auch wenn dies in den letzten 20 Jahren nur einmal passierte).

Meine externen Festplatten zur Archivierung sollten weiterhin zum Einsatz kommen. Hierfür verwendete ich Rahmenlose 3,5“ Einschübe im PC-Gehäuse. Das hat den Vorteil, dass ich die Festplatten „Bare-Metal“, also ohne irgendwelche Gehäuse in den Einschub stecken kann.

Die genutzten Speicherkapazitäten meines bisherigen Systems gaben vor, dass ich für Betriebssystem und die Anwendungssoftware circa 200 GByte benötigen würde. Die Nutzdaten belegten aktiv rund 350 GByte. Das erscheint wenig, liegt aber daran, dass ich alle nicht benötigten Daten auf die bereits genannten Archiv-Festplatten auslagere und Arbeitsdaten für Videoprojekte ebenfalls von diesen beziehe. Ich benötige somit keine übergroße Kapazität im Rechner.

Das Grundkonzept

Zunächst ging es um die Wahl der Plattform. Ganz klassisch bleibt die Wahl zwischen AMD und Intel. Zwar habe ich keine grundlegenden Vorbehalte gegen AMD – hier gibt es sehr vernünftige und sehr leistungsfähige Systeme – dennoch bin ich traditionell auf der Intel-Plattform heimisch. Somit lag mein erster Blick auf den verfügbaren CPUs. Intel hatte hier in das Lineup der Core i-Serie deutlich verändert. Zu den früheren Core-i3, i5 und i7 CPUs gesellten sich inzwischen auch Core-i9-Varianten. Auch die anzahl der Kerne wuchs weiter und weiter.

In meinem bisherigen System verrichtete ein Core i7-860 (4 Kerne, 8 Threads, 2,8 GHz Basistakt, 3,46 GHz Turbotakt) seinen Dienst. Ein i7 hätte es wieder werden dürfen und selbst ein i5-Modell mit 6 Kernen hätte genügt. Mich reizte aber eine sehr „umstrittene“ CPU, die in ihrer Klasse an Grenzen geht – den Intel Core i9-9900K! Diese CPU bietet 8 Kerne mit Hyperthreading (somit 16 Tasks) und der Möglich der Übertaktung auf 5 GHz auf allen Kernen (oder sogar höher). Dabei erzeugt diese CPU ordentlich Hitze und im Allgemeinen wird davon gesprochen, dass diese nur mit einer Wasserkühlung zu betreiben ist. Doch auch dazu später mehr.

Für System und Daten sollten es ursprünglich 4 SSD jeweils paarweise im RAID1-Verbund werden. Also Zwei Volumes, eines für das System und Anwendungen, eines für die Daten. Zusätzlich war der Plan eine SSD für Cache-Aufgaben zu verwenden (Auslagerungsdatei, Audio/Video-Caches, usw.) Hinzugekommen wären dann drei Hot-Swap-Festplatteneinschübe und ein BluRay-Brenner. Somit hätte ich meine alte Struktur in neuem System wiedergeboren.

Bisher genügten mir 16 GByte RAM, diese wurden daher wieder eingeplant. Bei der Grafikkarte fühlte ich mich bisher bei NVidia zuhause, daher sollte es auch wieder eine NVidia-GPU werden. Hier vollzog sich gerade ein Generationenwechsel, denn zu den Shadern&Co. gesellten sich nun Raytracing-Kerne. Somit stellte sich die Frage GTX oder RTX? Eine GTX des mittleren Preissegmentes würde sicher genügen – dachte ich zumindest.

Zusammengefasst sollte es grob so aussehen:

- Intel Core i9-9900K

- Eventuell eine AIO-Wasserkühlung (Also eine All in One-Lösung)

- Geeignetes Mainboard von Gigabyte, Asus oder MSI

- 2x 500 GByte SSD (System und Software)

- 2x 500 GByte SSD (Daten)

- 1x 250 GByte SSD (Cache, Scratch)

- Bezahlbare Grafikkarte GTX 10×0 oder RTX 20×0

- BD-Brenner

- 3x SATA-HDD-Einschübe (Hot-Swap-Fähig)

- Passendes Netzteil ~500 Watt (Je nach Gesamtbedarf)

- Midi-Tower

Aber was ist schon ein guter Plan wenn man sich auch mit Problemen beschäftigen kann…

Die Schwierigkeiten

Bei der Planung stellte ich schnell fest, dass meine bisherige Strategie (viele interne Laufwerken) mit der aktuellen Technik nicht mehr funktionieren würde. Mein bisheriges System belegte stattliche 10 SATA-Ports. Aktuelle Chipsätze und Mainboards haben jedoch in der Regel „nur noch“ 8 SATA-Ports. Das liegt an der begrenzten Anzahl verfügbarer PCIe-Lanes von CPU und Chipsatz (zumindest in dieser Preiskategorie und Plattform). Meine Planung sah vor, dass ich mit den SSDs, den Einschüben und dem Brenner bereits 9 SATA-Ports benötigen würde. Das würde so nicht funktionieren. Ich überlegte daher einen zusätzlichen SATA-Controller einzubauen. Doch bei genauerer Überlegung war dieser unnötig, denn heutige Mainboards bieten die Möglichkeit, SSDs direkt auf dem Mainboard per M.2-Anschluss zu installieren. Hier werden Modellabhängig meist 1-3 M.2-Ports angeboten. Das sah nach einer Lösung aus. So hätte ich die für System und Anwendungen zwei M.2-SSDs einbauen können. Leider durchkreuzte auch hier die begrenzte Anzahl an PCIe-Lanes den ursprünglichen Plan. Denn die Mainboard-Hersteller verteilen die PCIe-Lanes je nach Ausrichtung unterschiedlich. Wenn man einen M.2-Port nutzt, wird meist ein SATA-Port deaktiviert (oft auch mehrere oder es werden PCIe-Steckplätze deaktiviert). Wie ich es auch drehte, es würde nicht passen (unabhängig von Mainboardhersteller und Typ). Ich wollte auf bestimmte Dinge jedoch nicht verzichten und suchte verzweifelt nach einer Lösung. Dazu dann im nächsten Abschnitt mehr.

Die Intel Core-i9-9900K-CPU sollte den Empfehlungen aus dem Web nach mit einer Wasserkühlung betrieben werden. Genauere Recherchen zeigten aber, dass dies nicht zwingend sein muss. Zudem hat auch eine Wasserkühlung verschiedene Nachteile.

Kompromisse

Der erste Kompromiss lag bei den Speichersystemen. Ich entschied mich, System, Anwendungssoftware und Daten auf ein gemeinsames RAID1 aus zwei großen SATA-SSDs zu setzen. Die Leistungsfähigkeit von SSDs reicht hier problemlos aus – auch die Haltbarkeit. Anders als früher, wo man aus performancegründen die Daten auf mehrere Medien verteilte, sollte es heute kein Problem sein, diese Daten auf nur einem Medium (respektive einem Array) zu mischen. Die Videodaten sollten dennoch auf einem eigenen Medium unterkommen, da dies weiterhin Performancevorteile bringt. Doch auch die Cache-Daten müssten ja irgendwo hin. Der Kompromiss war nun, eine einzelne SSD per PCIe auf einen M.2-Port des Mainboards zu setzen. Hier wird die SSD mit 4x PCIe angebunden, was – zumindest in der Theorie – eine hohe Transferleistung (bis zu 32 GBit/s) bringen sollte. Die hohe Transferleistung und die geringe Latenz von SSDs sollten beim Videoschnitt spürbare Vorteile bringen. Hier sollte ich auch die Cache-Daten unterbringen – nicht perfekt, aber sicher ausreichend. Dass dieses Laufwerk kein RAID-Array ist birgt zwar gewisse Datenverlustrisiken, ist aber zu vertreten. Hier liegen später nur Daten die bei Datenverlust wiederherstellbar sind.

Beim Mainboard habe ich mich (aufgrund der Lane-Sharing-Konfiguration) letztlich für das Gigabyte Z390 Aorus Ultra entschieden. Hier bleiben bei Nutzung eines M.2-Ports mit PCIe-SSD alle SATA-Ports des Mainboards aktiv. Zudem besitzt das Board insgesamt drei M.2-Anschlüsse, was spätere Erweiterungen möglich macht (dann aber mit SATA-Port-Verlusten).

Somit sind nun 6 SATA-Ports belegt: 2x SSD, 1x BD-Brenner, 3x SATA-Wechseleinschub. Es bleibt jetzt sogar noch Luft für Erweiterungen.

Da die neu geplante Schnittsoftware gerne viel RAM und eine leistungsfähige Grafikkarte mit mindestens 8 GByte RAM hätte (ihr Wunsch sei mir Befehl), wurden aus den geplanten 16 GByte RAM dann 32 GByte. Viel hilft viel… manchmal… zumindest in diesem Fall!

Die Wahl der Grafikkarte verlagerte ich strategisch von der guten Mittelklasse in die Oberklasse. Ich landete dann – aus Gründen – bei einer RTX 2070 mit 8 GByte RAM und somit nur eine Stufe unterhalb der zu diesem Zeitpunkt größten RTX-Karte von NVidia. Ich wollte dann doch die neueste Serie nehmen – allerdings für einen stolzen Preis! Der Geruch von Luxus…

Die allgemein empfohlene Wasserkühlung wäre eine Option gewesen, jedoch stören mich an einer solchen Lösung die höheren Kosten, der Aufwand und etwaige Wartungsarbeiten (zumindest bei einer Custom-Wasserkühlung), die Unterbringung des Radiators und es bleibt für mich generell die Frage offen, ob es wirklich absolut unabdingbar für den Betrieb einer i9-9900K CPU wäre. Die für mich interessantere Herausforderung war, diese CPU – gerade wegen der vielen „Behauptungen“ im Netz – mit Luft zu kühlen. Ich liebe solche Herausforderungen, obgleich ich mir bewusst war, dass ich nicht „die volle Leistung“ der CPU abrufen können würde. Hierzu werde ich später ebenfalls noch einige Zeilen schreiben.

Das geplante Midi-Gehäuse wäre nun aus gleich zwei Gründen zu klein geworden. Der massive Kühlkörper mit 165 mm Bauhöhe hätte nur ganz knapp hineingepasst, zudem benötige ich langfristig vier 5¼ Zoll Schächte. Belegt würden zwei Positionen durch den kompakten 3-fach-HDD-Wechselrahmen und einem BD-Brenner. Ein freier Slot soll später gegebenenfalls Platz für eine Erweiterung lassen (z.B. einem Frontpanel mit Kartenleser). Die Entscheidung fiel hier auf ein Gehäuse des deutschen Herstellers Nanoxia, dem schallgedämmten Nanoxia Deep Silence 5 (Rev. B in schwarz). Ein wuchtiges, stabiles und sehr flexibles Gehäuse.

Es gab also durchaus markante Abweichungen von meiner ursprünglichen Konfiguration. Sicher, man könnte es auch preisgünstiger gestalten, aber irgendwie waren mir solche harten Kompromisse unangenehm, denn wenn ich schonmal ordentlich Geld in eine neue Maschine stecke, möchte ich mich nicht später ärgern oder schon nach wenigen Monaten erneut investieren müssen.

Die Finale Hardwareauswahl

Das System sollte nach diesen Überlegungen und Entscheidungen dann aus folgenden Komponenten bestehen:

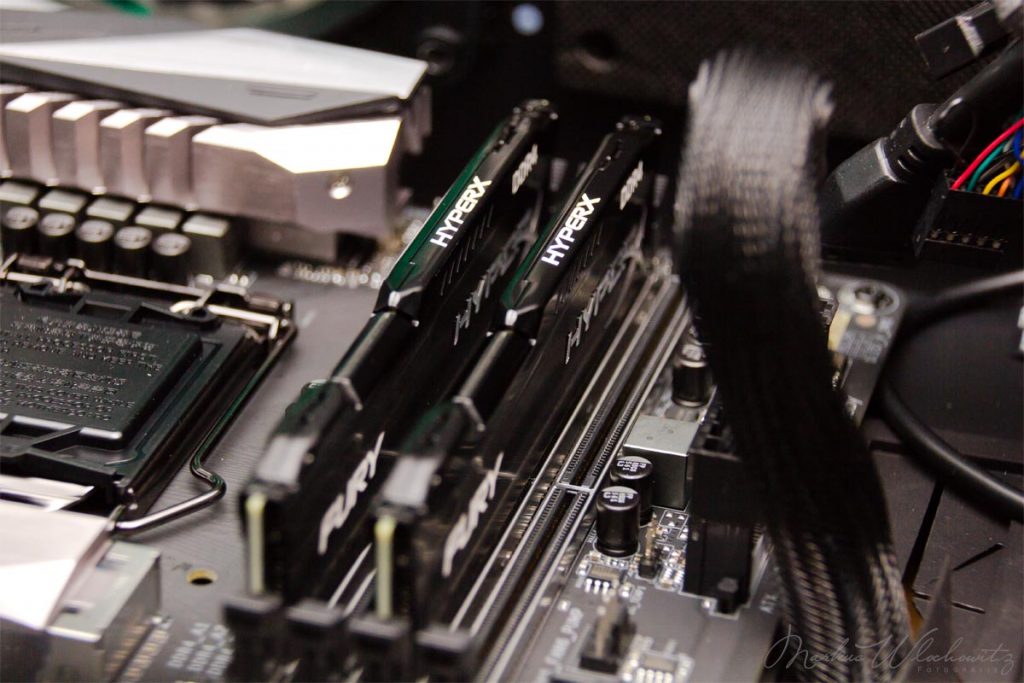

- CPU: Intel Core i9-9900K

- Mainboard: Gigabyte Z390 Aorus Ultra

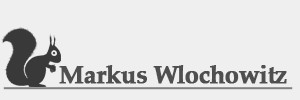

- RAM: 32 GByte HyperX FURY DDR4-2666 DIMM CL16-18-18-29 Dual Kit

- M.2 SSD: 1x 500 GB Samsung 970 Evo Plus M.2 2280 PCIe 3.0 x4 NVMe 1.3 (MZ-V7S500BW)

- SATA SSD: 2x 1 TB Samsung 860 Evo 2.5″ SATA 6Gb/s 3D-NAND TLC (MZ-76E1T0B/EU)

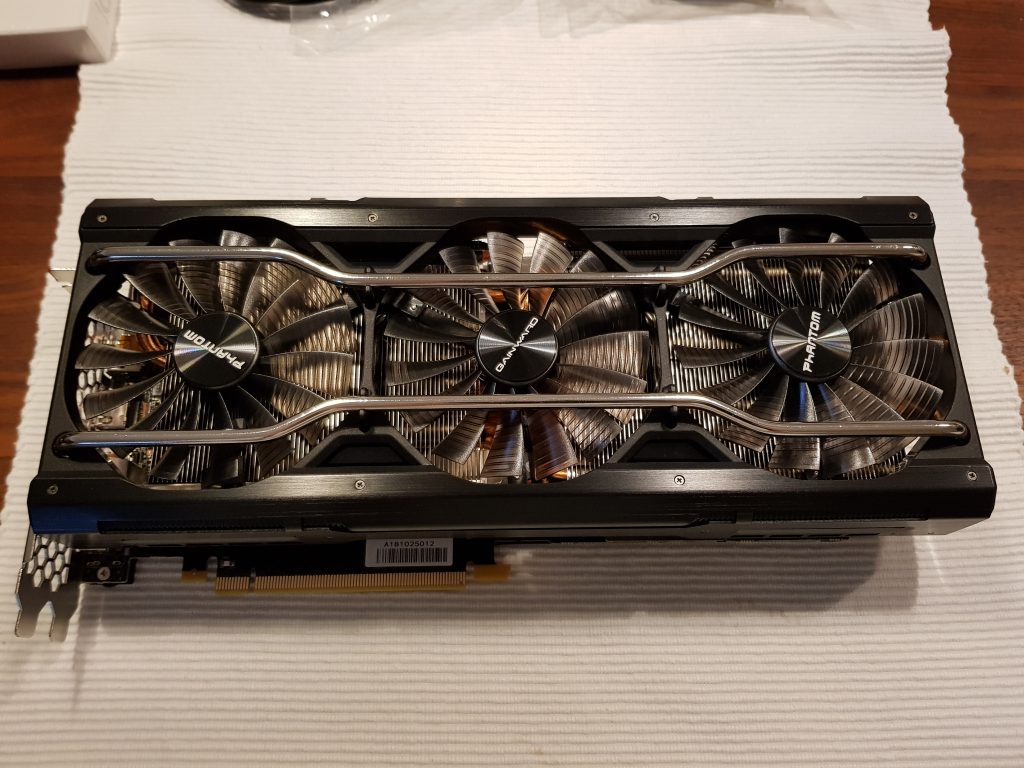

- Grafikkarte: Gainward GeForce RTX 2070 Phantom GS 8GB, PCIe 3.0 x16 1xHDMI 2.0 / 1xUSB-C / 3xDisplayPort

- CPU-Kühler: EKL Alpenföhn Brocken 3 Tower Kühler

- HDD-Einschübe: Icy Dock FlexCage MB973SP-1B 3.5″ SATA

- BluRay-Brenner: LG Electronics BH16NS55 Blu-ray Disc Writer SATA intern

- Gehäuse: Nanoxia Deep Silence 5 (Rev. B, gedämmt, Schwarz)

- Netzteil: 650 Watt Antec EarthWatts Pro Modular 80+ Gold

- CPU-Wärmeleitpaste: Thermal Grizzly Kryonaut Wärmeleitpaste

Zusätzliche Details

Erwähnen möchte ich noch detailliertere Gründe zur Wahl bereits genannter und weiterer Komponenten.

Die CPU: Die Intel Core i9-9900K bot zum Kaufzeitpunkt auf dem Sockel 1151 ein sagenhaftes Leistungspotential. Mit 8 Kernen und 16 Threads, einem Turbo-Boost-Takt von 5 GHz oder höher und einer dadurch optimalen Chance sowohl Single-Core als auch Multi-Core-Anwendungen optimal zu betreiben, waren einfach zu fantastisch um nicht neugierig zu sein. Wenn auch zu einem hohen Preis und gewissen „Hitzeproblemen“. Preisgünstigere CPUs wären eine Option gewesen, doch die Kostenersparnis gegenüber der 9900K war in meinen Augen nicht ausreichend groß, zumindest im Vergleich zum Rechenleistungsverlust.

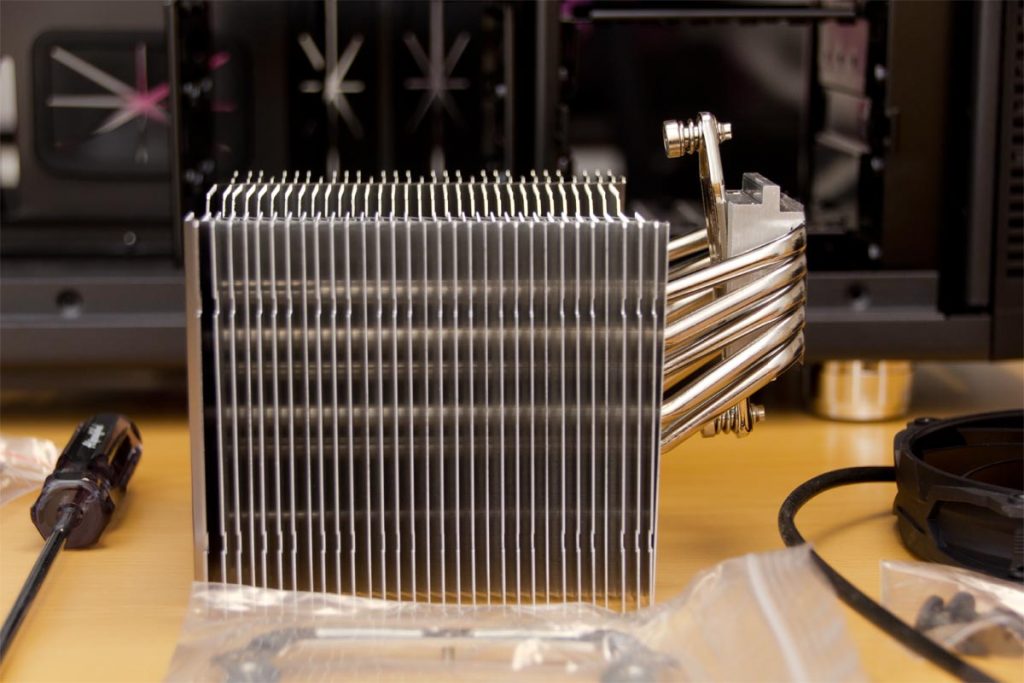

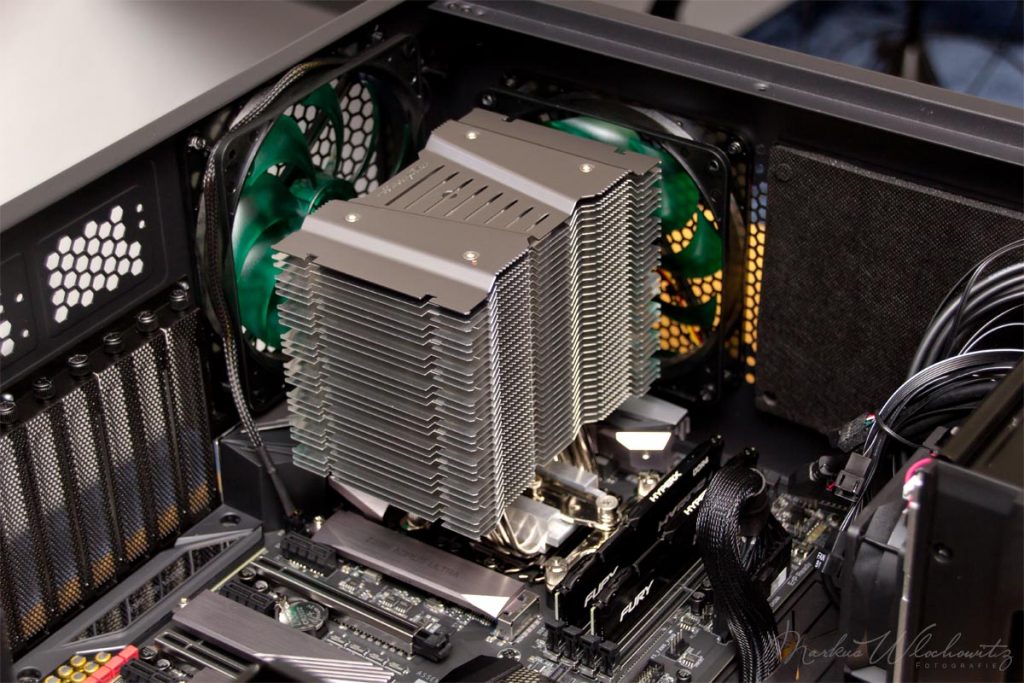

Der CPU-Kühler: Wie eingangs erwähnt stellte ich mich der Herausforderung eine solch leistungsfähige CPU mit einem Luftkühler zu betreiben. Tollkühn? Vielleicht. Gewählt habe ich den Alpenföhn Brocken 3 des deutschen Herstellers EKL, ein geradezu gigantischer Tower Kühler (850 Gramm, 146 x 165 x 125 mm). Aufgeschnallt bekommt er vom Hersteller einen 140 mm PWM-Lüfter mit knapp über 100 m³/h Luftdurchsatz. Die Basisplatte mit Direct-Touch und 5x 6mm Heatpipes soll laut EKL bis zu 220 Watt abführen können. Das ist beeindruckend und sollte einer einfachen AIO-Wasserkühlung ebenbürtig sein können (so der Plan). Die angegebenen 400-1050 U/min bei maximal 22dB(A) dürften den Geräuschpegel auf einem erträglichen Niveau halten. Alternativ hätte es auch der aus Österreich stammende Noctua Doppelturm-Kühler NH-D15 werden können. Dieser hat – laut verschiedener Tests – eine noch größere Kühlleistung. Er arbeitet jedoch mit zwei getrennten Türmen und zwei Lüftern. Irgendwie war das nicht ganz mein Ding und er war auch gut doppelt so teuer wie der Brocken 3.

Die Wärmeleitpaste: Auch diese ist eine nicht zu unterschätzende Komponente beim PC-Bau. Man darf sie aber auch nicht überschätzen. Das Thema Wärmeleitpaste wird zum Teil fast religiös in der Community behandelt. Auch hier lasse ich gerne jedem seine ganz persönliche Sichtweise. Flüssigmetall wäre eine interessante Lösung gewesen. Das aus Gallium bestehende Flüssigmetall hat einen großartigen Wärmeleitwert. Allerdings ist es auch elektrisch leitfähig was ein Risiko bedeutet und man muss sehr sorgfältig arbeiten. Weiter ist es ein Material, welches mit Kupfer eine Legierung eingeht und Aluminium auflöst. Es kann im ungünstigen Fall die Oberfläche des CPU-Heatspreader sowie der Bodenplatte des Kühlkörpers angreifen. Elektrisch nichtleitende Wärmeleitpasten gibt es aber auch mit sehr guten Wärmeleitwerten. Ein zum Zeitpunkt des Kaufs sehr gutes Produkt der Firma „Thermal Grizzly“ aus Hamburg nennt sich „Kryonaut“. Dieses war für meine Zwecke gut geeignet. Die Hochleistungspaste ist zwar recht zäh (Viskosität 120 – 170 Pa·s), lässt sich aber prima einsetzen und ist über sehr lange Zeit stabil. Laut Hersteller besitzt sie eine Wärmeleitfähigkeit von 12,5 W/(m·K). Flüssigmetall (Gallium) besitzt hier im Vergleich zwar eine sehr viel höhere Wärmeleitfähigkeit von über 70 W/(m·K), das sollte man jedoch nicht überbewerten. Preisgünstige und durchaus gängige Wärmeleitpasten bewegen sich meist zwischen 4-8 W/(m·K). Nur in extremen Übertaktsituationen (z.B. Helium oder Stickstoffkühlungen, etc.) macht es einen großen Unterschied welche Wärmeleitpaste oder ob Flüssigmetall verwendet wird. Das, was der engagierte Tuner Zuhause macht, fällt hier nicht in diese kritische Kathegorie. Da sind andere Parameter deutlich wichtiger.

Das Mainboard: Das Gigabyte Z390 Aorus Ultra bot mit dem zum Kaufzeitpunkt höchsten Intel-Chipsatz Z390 und für die 9. Generation optimierte Spannungsregler beste Voraussetzungen zum Betrieb einer Intel-i9-9900K. Der solide Aufbau des Mainboards und die für meine Zwecke optimale Abstimmung der Mainboard-Konfiguration waren ebenso wichtige Kriterien. Das Board ist als Übertakter-Mainboard ausgelegt und bietet alle Möglichkeiten der Optmierung (und begünstigt den Spieltrieb des Käufers). Zu diesem Mainboard könnte man einen eigenen, umfassenden Artikel schreiben und ohne Frage ist das Mainboard eine der wichtigsten Komponenten beim Systembau. An dieser Stelle möchte ich weitere Details jedoch aussparen, da dies den Rahmen wahrlich sprengen würde.

Der RAM: Die 32 GB sind in zwei Modulen zu 16 GB aufgebaut um einen Dual-Channel Betrieb zu ermöglichen. Die gewählten HyperX FURY sind konventionelle DDR4-2666 DIMMs mit einer „vernünftigen“ (nicht übertriebenen) CAS-Latenz von 16 Zyklen (CL16-18-18-29). Zwar gäbe es hier die Möglichkeit Module mit deutlich schnellerer Taktung zu wählen (Mainboard und Chipsatz würden das hergeben, bis über 4400 MHz), doch profitierte ich nur sehr begrenzt von schnellerem Speicher-Takt und die Kosten sowie die Risiken von Instabilitäten erspare ich mir an dieser Stelle. Hier bleibe ich gerne „konservativ“ und die Latenz von 16 Zyklen ergeben bei 2666 MHz (DDR) gute 12ns Latenzzeit. Wichtig bei der Wahl des RAM ist, dass er zum Mainboard/Chipsatz kompatibel ist. Nicht jede RAM-Konfiguration funktioniert, denn die Art der Speicheranbindung und Adressierung obliegt dem Mainboard-Hersteller und kann stark variieren. Auch wenn synthetische Benchmarks zeigen, dass schneller getakteter RAM und/oder kürzere Latenzen mehr Datendurchsatz liefert und beispielsweise das komprimieren und dekomprimieren von Datenarchiven dadurch beschleunigt werden, bleibt es in der Praxis ein kaum spürbarer Vorteil den man sich meist sehr teuer erkauft. Es liegt wie so oft am Anwendungsfall. Ich baue aber ein Arbeitsgerät und keinen wettbewerbstauglichen Overclocker-PC. Hier ist ein gesundes Augenmaß gefragt und es gibt wichtigere Parameter als den Speichertakt.

Die M.2 SSD: Hier wählte ich eine 500 GB große Samsung 970 Evo Plus. Diese wird auf dem Mainboard am M.2-Port angeschlossen. Sie nutzt PCIe 3.0 mit 4 Lanes und kommuniziert per NVMe 1.3 Protokoll. Vorteile sind hier ist der hohe Datendurchsatz und die geringe Latenz. Die Evo Plus-Serie nutzt TLC-Flash-Speicherzellen (Triple Level Cell) die drei Bit pro Zelle speichern können. Dem Vorgeschaltet ist ein hochwertiger SLC-Cache (Single Level Cell). Samsung erreicht so zu einem vernünftigen Preis eine hohe Lebenserwartung von 1,5 Millionen Stunden (MTBF laut Hersteller). Samsung gibt die Geschwindigkeiten an mit 3500MB/s Lesen und 3200MB/s schreiben, wobei letzteres für den SLC-Cache Speicher gilt. Ist der Cache ausgereizt bleiben noch 900MB/s beim direkten Schreiben auf die TLC-Zellen übrig. Auch die 4K IOPS lesen/schreiben liegen mit 480k/550k auf einem hohen Niveau. Ein guter Kompromiss und für meine Zwecke mehr aus ausreichend.

Die SATA SSDs: Für System und Daten sollen zwei 1TB SSDs von Samsung in ein RAID1-Array genutzt werden (Datenspiegelung). Hier bietet die Samsung 860 Evo (eine 2.5″ SATA SSD mit SATA-3 6Gb/s) ausreichend Kapazität und Leistung. Auch hier kommt ein 3D-NAND TLC zum Einsatz. Hier sollen 550MB/s lesend und 520MB/s (500MB/s TLC) schreibend erreicht werden. Ebenso kommt ein SLC-Cache zum Einsatz. Die 4K IOPS lesen/schreiben 98k/90k sind deutlich geringer als bei der PCIe-Version, was naturgemäß an der SATA-Schnittstelle und dem dort verwendeten Protokoll liegt.

Die Grafikkarte: Die Videoschnittsoftware „DaVinci Resolve“ wünscht sich eine potente Grafikkarte mit mindestens 8 GByte RAM. Ich hatte grundsätzlich nichts gegen etwas „größeres“, auch hinsichtlich der Option „Zocken!“ (was bei mir selten vorkommt, aber nunja). Daher entschied ich mich für eine Gainward GeForce RTX 2070 Phantom GS 8GByte. Die Marke Gainward wählte ich schlicht aus persönlicher guter Erfahrung der letzten 15 Jahre. Gainward ist eine Marke von „Palit Microsystems“, dem ebenfalls bekannten Hersteller. Die Karte bringt neben der guten Leistung auch alle Voraussetzungen zum Anschluss eines HmD in Form eines Virtual-Reality-Headsets mit. In dieser Ausführung bietet die Karte 1x HDMI 2.0, 3x DisplayPort und 1x USB-C. Die RTX 2080 hätte fraglos noch mehr Leistung geboten, doch war ich bereits weit außerhalb dessen angekommen, was ich bei der GPU-Leistung (und den Kosten) ursprünglich geplant hatte. Es muss ja nicht immer das absolute Maximum sein. Nicht immer. Wirklich nicht. *hüstel*

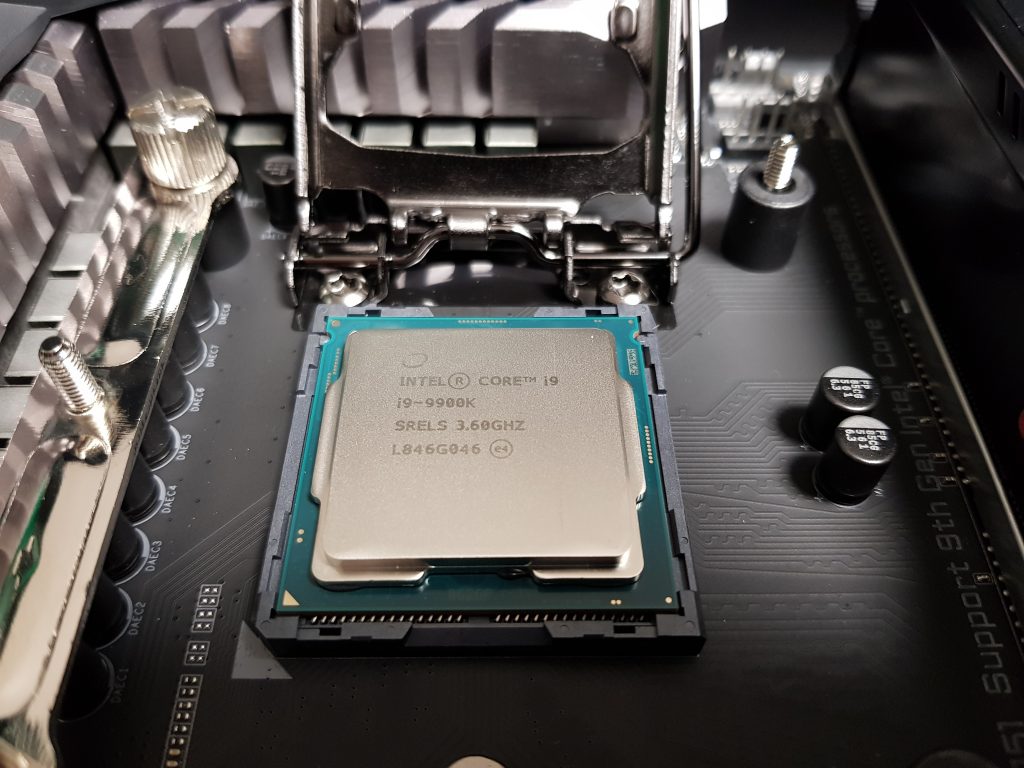

Die HDD-Einschübe: Um drei Festplatten flexibel nach Bedarf anschließen zu können verwende ich traditionell rahmenlose Einschübe für 3 ½ Zoll Festplatten. Gewählt habe ich das platzsparende Modell Icy Dock FlexCage MB973SP-1B 3.5″ für drei SATA-Festplatten. Dies belegt nur zwei 5 ¼ Zoll Einschübe im Gehäuse. Es besitzt einen Lüfter der bei eingesetzter Festplatte aktiviert wird um entstehende Wärme ins PC-Gehäuse abzuführen. Hierzu ein Wort der Warnung! Der in meinem Fall vom Hersteller verbaute Lüfter ist der Hölle entsprungen. Zumindest was den Lärm betrifft. Den Begriff „Hochleistungsgebläse“ halte ich für Angemessen. Was sich Icy Dock dabei gedacht hat erschließt sich mir nicht. Ich habe den verbauten Lüfter gegen ein leises und dennoch leistungsfähiges Modell NF-A8 des Herstellers Noctua ersetzt. Dies verrichtet gute Dienste und ist praktisch unhörbar.

Der vom Hersteller verbaute sehr laute Lüfter.

Geliefert wird der Lüfter in einer schicken Schachtel mit Lüfter, Montagematerial und Zubehör.

Der NF-A8 von Noctua ist ein laufleiser aber leistungsfähiger 80mm Lüfter.

Der BluRay-Brenner: Hier habe ich einen Multiformat-Brenner von LG gewählt, genauer das Modell BH16NS55. Ein gängiger 5¼ Zoll Multiformat-Brenner mit SATA-Anschluss. Inzwischen können – meines Erachtens – zwischen den Modellen und Herstellern kaum mehr große Unterschiede gefunden werden. Für den Alltagsgebrauch genügt mir hier ein Standardmodell. Immerhin kann dieser Brenner von der klassischen CD über mehrlagigen BDs bis hin zu M-Disk und BDXL alles verarbeiten.

Das Gehäuse; wird ein Big-Tower des deutschen Herstellers Nanoxia. Das Deep Silence 5 (hier in Revision B in schwarz) ist ein schallgedämmtes, großes Gehäuse mit reichlich Platz und Möglichkeiten. Hier passt der große Kühlkörper problemlos hinein. Es sind vier 5 ¼ Zoll Schächte vorhanden. Insgesamt bietet das Gehäuse reichlich Platz und Volumen. Die Position des Ein/Aus-Tasters und den USB-Anschlüssen ist obenliegend gut zu erreichen, für mich jedoch nicht absolut perfekt positioniert. Hier hätte ich mir gewünscht dass diese vorne oder verdeckt liegen. Das ist aber eine persönliche Sache basierend auf dem Standortbei mir im Raum und der Tatsache, dass ich gerne weitere Geräte auf dem PC-Gehäuse abstelle. Leider fehlt auch eine USB-C-Buchse. Diese war aber zum Kaufzeitpunkt auch bei anderen Gehäusen eher selten. Die Buchse lässt sich bei Bedarf später durch eine 5¼ Zoll Frontblende nachrüsten.

Das Netzteil: Aufgrund der möglicherweise hohen Spitzenlasten durch CPU und Grafikkarte habe ich mich für ein leistungsfähigeres Netzteil mit 650 Watt entschieden. Rechnerisch wäre ein 550 Watt-Netzteil optimal gewesen. Aus einem für mich eher unüblichen Bauchgefühl heraus (und weil es nur 3 € mehr kostete) habe ich dann beim nächst größeren Modell zugeschlagen.

Ich habe sehr gute Erfahrungen mit dem US-amerikanischen Hersteller Antec gemacht. Dieser bot in den letzten Jahren stets eine solide Ingenieursleistung für einen angemessenen Preis. Daher wählte ich das Antec EarthWatts Pro Modular 80+ Gold aus. Hier handelt es sich um ein Energieeffizientes Netzteil, das auf den drei Spannungen +3.3V 20A, +5V 20A und +12V 54A liefern kann. Wie ein Netzteil aufgebaut sein sollte, wie viele Stromschienen es besitzt und all die vielen Fragen der Technik sind genauso kontrovers diskutiert wie bei vielen anderen Komponenten. Auch dazu ließe sich umfassend berichten. Ich belasse es bei der Aussage, dass ich mit der hier gebotenen Technik aus verschiedenen Gründen, sorgfältiger Prüfung und gutem Gefühl sehr zufrieden bin. Auch wenn – und das muss ich zugeben – die gewählte Leistungsgröße mit 650 Watt des Guten zu viel sind und ich somit am „Optimum“ verbeischrappe. Hier hat mir die CPU durchaus Respekt eingeflößt und meinen „Sachverstand“ manipuliert. Doch mit dem etwas schlechteren Wirkungsgrad im Ruhe- und Normalbetrieb werde ich leben können.

Der Zusammenbau

Die Montage aller Komponenten in das Gehäuse ist schon fast ein spiritueller Akt. Immerhin verheiratet man nun all das, was man sich lange und umfassend überlegt hat. Man hofft dass alles passt und dass das System anschließend problemlos hochfährt.

Nachdem alle Komponenten ausgepackt und begutachtet wurden wird zunächst das Gehäuse vorbereitet. Die Seitenwände müssen selbstredend entfernt werden um Komponenten und Leitungen einzubauen. In meinem Fall sind die Seitenwände mit Dämmatten beklebt. Dies dient der Schallreduktion. Das Gehäuse bietet reichlich Raum für alle Komponenten und somit ist es auch einfach alles einzubauen. Kleinere Gehäuse haben durchau die Eigenschaft spuren an den Händen zu hinterlassen, diese Gefahr ist beim großen Nanoxia-Gehäuse jedoch nicht gegeben.

Damit später die Wärme gezielter abgeführt werden kann, habe ich einen vorverbauten Lüfter von vorne nach oben verlegt, da wir oberhalb des CPU-Kühlers die höchste Wärmeableitung realisieren müssen. In meiner Konfiguration sauge ich die warme Luft oben aus dem Gehäuse heraus. Nur ein Lüfter vorne bläst frische Luft in das Gehäuse hinein.

Ebenso wurde ein nicht benötigter Festplattenkäfig entfernt. Hierdurch wird auch der Luftstrom des verbliebenen Frontlüfters, der später in Richtung Grafikkarte bläst, optimiert.

Der vordere 5¼ Zoll Bereich des Gehäuses wurde nun mit den Wechselplattenmodul und dem BD-Brenner bestückt.

Der 3-fach Einschub vor dem Einbau.

Der 3-fach Einschub vor dem Einbau in der Seitenansicht mit vorinstalliertem Lüfter.

Die vier noch abgedeckten 5 1/4″ Einschübe.

So passen drei 3 1/2″ HDDs in zwei 5 1/4″ Einschübe.

Hier mit bereits eingebautem Multiformat-Brenner.

Als nächstes folgt das Mainboard. Beim Einbau ist darauf zu achten, dass alle Montagepunkte an den richtigen Stellen im Gehäuse befestigt werden und die Platine stabil – aber nicht mit Gewalt – angeschraubt wird. Wir wissen: Nach Fest kommt Ab!

Das Gigabyte Z390 Aorus Ultra, ausgewählt nach den persönlichen Notwendigen.

Das Gigabyte Z390 Aorus Ultra bietet viele Erweiterungsmöglichkeiten, vor allem drei m.2- und drei PCIe-Slots.

Das Mainboard hat seinen neue Heimat bezogen.

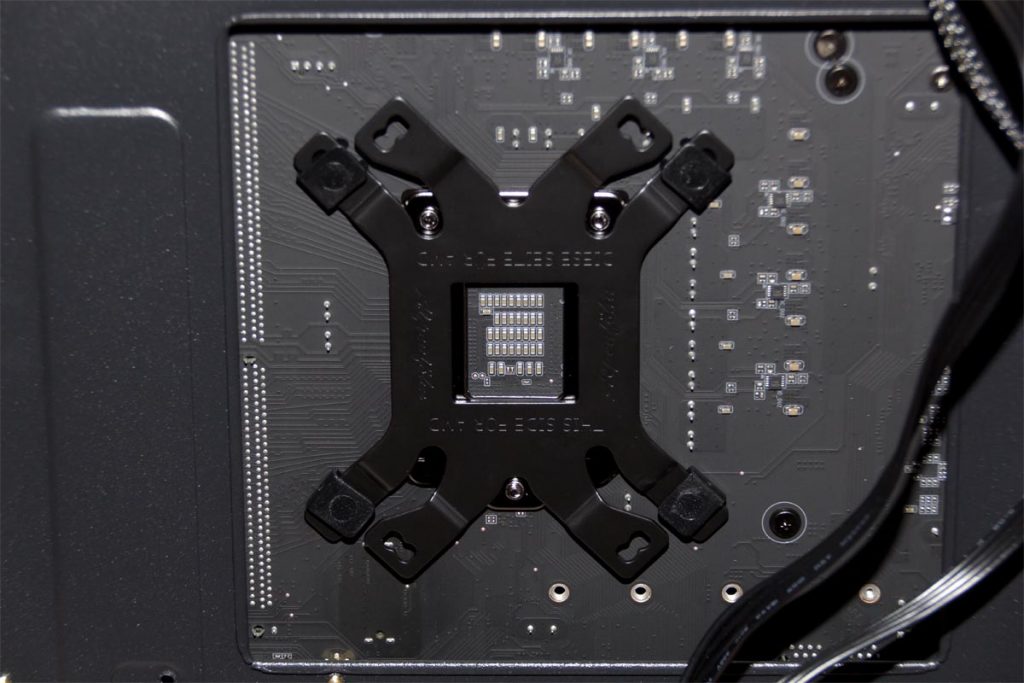

Im nächsten Schritt sollte die Halterung für den CPU-Kühler montiert werden. EKL liefert Teile für verschiedene Prozessoren mit. Die Halterung wird von hinten mit einer Backplate aufgebaut, damit der schwere Kühlturm später gut fixiert wird und sich das Gewicht verteilen kann. Wer solch ein System später transportieren möchte oder muss sollte darauf achten, dass das Gehäuse im liegen transportiert wird und die Kräfte möglichst nicht wie eine Brechstange auf das Mainboard wirken.

Die montierte Halterung für den Kühlkörper. Hier kommt später noch die CPU dazwischen.

Da der Kühlkörper ein ordentliches Gewicht mitbringt, ist die Halterung auf der Rückseite entsprechend stabil von EKL ausgelegt worden.

Wie im Bild zu erkennen ist, habe ich auch die beiden RAM-Module bereits eingesetzt. Die beiden Module hatte ich bereits vor der Montage der CPU-Kühler-Halterung eingesetzt. Aus leidlicher Erfahrung weiß ich nämlich, dass der Einbau von RAM-Modulen eine Qual sein kann, wenn bereits ein großer Kühlkörper eingebaut ist.

Im Innenbereich ging es weiter mit den Speichermedien. Die M.2-SSD fand ihren Platz auf dem Mainboard. Hier wählte ich den M.2-Anschluss, der keine Shared-Lanes verwendete die mir später Probleme machen konnten.

Das Gigabyte-Mainboard besitzt für alle drei M.2-Ports jeweils einen metallischen Kühlkörper mit einem Wärmeleitpad. Dieses muss vor der Installation der SSD entfernt und anschließend wieder angebracht werden. Es soll die Kühlung des Speichermediums unterstützen. Inwiefern dies nötig ist mag man sich sicher fragen, doch gibt es gerade bei den PCIe-SSDs aufgrund der hohen Transferraten durchaus eine Berechtigung für eine zusätzlcihe Kühlung der Chips. Schick aussehen tut es jedenfalls und es ist im besten Falle der Lebenserwartung der SSD zuträglich.

Die beiden SATA-SSDs montierte ich klassisch in den vorhandenen Festplattenrahmen. Hier haben sie noch ausreichend Luft, auch wenn SSDs nicht all zu warm werden. Ein wenig Kühlung schadet ihnen nicht. Man könnte die SSDs auch auf die Rückseite hinter dem Mainboard montieren, der Gehäusehersteller hat hierfür entsprechende Plätze mit Montagemöglichkeiten vorgesehen. Ich finde es jedoch praktischer diese in den Käfig zu setzen, sollte ich doch mal wieder Hand daran legen müssen.

Anschließend ging es an das Herzstück des Systems, der CPU. Allein die Verpackung die Intel hier liefert zeigt, wie außergewöhnlich dieses Stück Technik ist. Intel verpackt den i9-9900K in einen transparent-blauen Pentagondodekaeder, der in einem schwarzen Samt-Beutel geliefert wird. Schick und auffällig… innen ist dann dennoch „nur“ eine unscheinbare CPU.

Ungewöhnliche Verpackung für eine ungewöhnliche CPU.

Okay, sieht schick aus, wird aber so nicht funktionieren. Also auspacken und ordentlich machen 😉

Nach dem auspacken der CPU findet diese ihren Platz auf dem 1151 Sockel des Mainboards.

Nun erfolgte die Montage des Kühlkörpers. Zuvor brachte ich die Wärmeleitpaste auf dem CPU-Deckel auf. Hierbei war zu beachten, dass es sowohl die richtige Menge, als auch die korrekte Verteilung der Paste gewährleistet wurde. Ich verwendete hier eine knapp erbsengroße Menge Paste und verteilte diese mittig in Form einer kleinen, flachen Wurst entlang der gedachten Fläche des CPU-Die.

Der Die des 9900K liegt mittig hochkant und hat eine rechteckige Form im Seitenverhältnis 2:1. Wichtig ist, dass die Fläche des Die und – in diesem Fall – der mit dem Deckel (IHS) verlöteten Teil vollflächig bedeckt wird. Auch wenn es vielfältige Empfehlungen und Vorlieben gibt, letztlich genügt im Grunde ein Kleks in der Mitte des Deckels. Durch das Anpressen der Grundplatte des Kühlkörpers verteilt sich die Paste üblicherweise ausreichend weit (bereits mehrfach getestet und demonstriert). Dennoch schadet es nicht, der Verteilung etwas zu helfen indem man die Geometrie des CPU-Die berücksichtigt. Es ist auch nicht zwingend nötig dass der CPU-Deckel vollständig bis zum Rand mit Paste bedeckt ist da dies – wie ebenso vielfältige Tests zeigten – kaum mehr Vorteile oder Einfluss auf die Wärmeableitung hat. Am Rand des Deckels ist kaum mehr wirksame Ableitfläche vorhanden. Wichtiger ist, dass nicht zu viel Paste aufgetragen wird. Das würde den Wärmefluss behindern, da die Wärmeleitpaste lediglich die feinen Unebenheiten schließen soll und eine zu dicke Schicht das Gegenteil bewirken würde.

Hier nochmal alle Teile des EKL Brocken 3

Die beiden Lüfter sollten die Abwärme schnell und ausreichend aus dem Gehäuse leiten.

Es sieht auf dem Foto nicht ganz so aus, aber der Kühlkörper ist wirklich beeindruckend wuchtig!

Die beiden Lüfter sollten die Abwärme schnell und ausreichend aus dem Gehäuse leiten.

Nach vorsichtiger aber stabiler Montage des Kühlturmes musste noch dessen Lüfter installiert werden.

Im nächsten Schritt wurde das Netzteil im unteren Teil des Gehäuses montiert und das Kabelmanagement genutzt um die nötigen Leitungen anzuschließen.

Nachdem alle Leitungen einigermaßen ordentlich im Gehäuse verlegt waren folgte die Grafikkarte. Diese setze ich immer zuletzt ein, da diese sonst den Zugriff auf die anderen Komponenten behindert. Zuletzt wurden noch die beiden Leitungen zur Stromversorgung angeschlossen.

Die RTX 2070 mit drei Lüftern und verchromten Zierstäben.

Vorne moderne Hochtechnologie, im Hintergrund historische Disketten… und Plüsch… und nein, das ist kein Kinderzimmer 😉

Unscheinbar, die Grafikkarte in der eingebauten Frontansicht.

Die Grafikkarte möchte gerne Strom, ganz viel davon…

Der erste Start

Einer der spannendsten Momente überhaupt, der erste Start. Selbstverständlich mussten zuvor Maus, Tastatur und Display angeschlossen werden. Dann folgte der große Moment. Durch einen Druck auf den Power-Taster am Gehäuse wurde der Befehl zu initialisieren gegeben. LEDs begannen zu leuchten, Lüfter liefen an, es piepste, über die Debug-LED-Anzeige des Mainboards flogen Ziffernpärchen und…

Nichts!

Das ist etwas, das man nicht haben möchte. Keine Anzeige am Display, dafür ein Fehlercode auf der Debug-Anzeige. Glücklicherweise zeigt das Mainboard hier anhand des Fehlercodes und speziellen LEDs an, wo sich der Fehler befindet. In diesem Fall angeblich beim RAM.

Die beiden RAM-Module hatte ich nach Herstellerangabe in die vorgesehen Slots gesteckt. Dennoch verweigerte das Board den Start. Die Module waren von mir geprüft und zum Mainboard voll kompatibel. Ebenso wurden die Module von Gigabyte auf der Kompatibilitätsliste geführt. Sollten die Module einen Defekt haben?

Wenn der RAM nicht erkannt wird oder Probleme macht, sollte der nächste Schritt immer darin bestehen die Module nochmals herauszunehmen, die Kontakte zu prüfen und ggf. zu reinigen und erneut einzusetzen. Das tat ich, jedoch ohne Erfolg. Anschließend sollte man die RAM-Slots wechseln oder die Module untereinander vertauschen. Ich wechselte daher auf die beiden anderen RAM-Slots und siehe da, dies gefiel dem Mainboard tatsächlich besser (abweichend von der Angabe im Handbuch). Jetzt wurden die 32 GByte vollständig erkannt und das System startete ins UEFI. *großer Jubel*

Das Gigabyte UEFI begrüßte mich mit folgendem Bildschirm:

Der erste Schritt war getan, nun ging es an die Einstellungen im UEFI. Nachdem ich mir einen allgemeinen Überblick verschafft hatte, überprüfte ich ob die Hardware ordnungsgemäß erkannt wurde. Die nötigsten Einstellungen wurden ebenso kontrolliert damit hier nichts schief gehen konnte. Anschließend erstellte ich mittels integriertem RAID-Manager aus den beiden SATA-SSDs ein RAID 1 Array als Vorbereitung zur Betriebssysteminstallation.

Die Ersteinrichtung

Im nächsten Schritt installierte ich das Betriebssystem. In meinem Fall ein Windows 10 Pro 64Bit mittels der ordnungsgemäß lizenzierten Microsoft Installations-DVD. Als Installationsziel wählte ich das gerade erstellte Raid 1 Array. Die Installation ging äußerst flink vonstatten. Nach gerade 12 Minuten begrüßte mich ein Windows Anmeldebildschirm. Kein Vergleich zu früher. Ich erinnere mich noch an die Zeiten in den frühen 1990er Jahren, als man Bergeweise Disketten nacheinander einlegen musste und eine Installation und Grundeinrichtung von DOS+Windows auch mal einen ganzen Tag in Anspruch nehmen konnte. Eine Erfahrung die mich heute bereits zum Opa der PC-Ära macht *seufz*. Ich erwähne nun besser nicht meine Erfahrungen mit meinem ersten Computer aus dem Jahr 1983, wobei dieser keine Installation benötigte, den schaltete man einfach ein. Der gute alte Commodore 64. Aber das ist ein anderes Kapitel.

Nacheinander verschwanden die Installationsmedien von Mainboard und Grafikkarte im optischen Laufwerk um alle nötigen Treiber zu installieren. Anschließend folgten noch einige kleinere Online-Updates und die Grundeinrichtung war abgeschlossen – zumindest hinsichtlich eines installierten und funktionsfähigen Betriebssystems.

Nachdem ich mich davon überzeugt hatte, dass zumindest die grundlegenden Funktionen der Maschine oberflächlich funktionierten, konnte ich mich der Stabilitätstests, der Feinabstimmung und dem großen Thema CPU-Optimierung widmen.

Abstimmung der CPU auf den Luftkühler

Die Intel Core i9-9900K CPU wird mit einem Basistakt von 3.6 GHz und einem maximalen Turbotakt von 5.0 GHz angegeben. Intel sieht hierbei vor, dass die 8 Kerne je nach Nutzung unterschiedlich getaktet werden können. So können einzelne Kerne auf 5 GHz und abgestuft mehrere Kerne auf kleineren Frequenzen getaktet werden (genauer gesagt 4,7-5,0 GHz). Dies nach Intel-Vorgabe jedoch immer nur für eine gewisse „kurze“ Zeitspanne. Denn Intel definiert die TDP mit 95 Watt und eine maximale Kern-Temperatur von 100°C. Das bedeutet, dass die CPU im Normalfall nicht lange mit hoher Taktung durchhält und anschließend den Takt wieder senkt. Auch beim Erreichen der maximalen Temperatur taktet die CPU ordentlich runter um nicht den Hitzetod sterben zu müssen. Wer also den Turbo bei 8 Kernen auf 5 GHz stellt, wird sehr schnell von der Schutzschaltung der CPU ausgebremst. Außer, er legt es bewusst darauf an und deaktiviert alle diese Mechanismen. Doch dann ist die CPU recht schnell ein Klümpchen nutzloses Silizium.

Aber das muss so nicht bleiben, denn schließlich ist es ein 9900K Modell mit offenem Takt und dieser auf einem Board für Overklocker. Also, ran ans Werk!

Zunächst testete ich Stufenweise aus, bis zu welchem Takt ich gehen konnte, ohne dass der Luftkühler überfordert war. Dazu verwendete ich Prime95 mit AVX Befehlssatz um eine maximale Last auf die CPU zu geben. Beginnend mit allen Kernen und langsam steigendem Takt näherte ich mich der Grenze meiner Luftkühlung. Dies wiederholte ich dann mehrfach mit weniger Last (weniger Kernen) systematisch, bis ich eine gute Abstufung ermittelt hatte. Ich testete ebenso die maximale Frequenz. Meine CPU bekam ich auf zwei Kernen auf bis 5,2 GHz. Allerdings stellte sich bei praxisbezogenen Tests heraus, dass dies im Leerlauf nicht immer stabil lief. Es war auch nicht mein Ziel diese Taktung jederzeit zu haben, denn die CPU ist auch unter „Normalbedingungen“ sehr leistungsstark. Man sollte seine Grenzen aber kennen… Prost!

Die CPU gönnte sich unter Volllast mit Prime95/AVX rund 200 Watt bei knapp 100°C. Nichts, was man auf Dauer halten sollte, aber prinzipiell ist dies in dieser Konfiguration möglich, trotz Luftkühlung. Allerdings nicht mit 5 GHz auf allen Kernen.

Als nächstes erstellte ich ein so ermitteltes abgestuftes Profil. Hier ergab sich folgendes:

- Last auf 1-2 Kernen: 5,1 GHz

- Last auf 3-4 Kernen: 5,0 GHz

- Last auf 5-6 Kernen: 4,9 GHz

- Last auf 7-8 Kernen: 4,8 GHz

Die UnCore-Frequenz beließ ich auf den Standardwerten. Ebenso war es hierfür nicht nötig die vCore-Spannung zu erhöhen. Somit blieb auch die Load-Line-Calibration auf Standard. Es war jedoch nötig den AVX Offset auf -1 zu stellen um die sehr hohen Lastspitzen bei Verwendung der AVX-Befehlssätze zu reduzieren.

Weitere praxisbezogene Tests zeigten, dass diese Einstellungen stabil unter Alltagsbedingungen liefen. Neben den synthetischen Tests mit Prime95 (mit und ohne AVX) sowie Rendering Tests mit Cinebench R20 teste ich ebenfalls mit RealBench von ASUS. Hinzu kamen diverse Anwendungen die ich manuell startete, Dateien öffnete und bearbeitete (Word, Excel, Firefox, Edge, CorelDraw 2017, Adobe Photoshop, Adobe Premiere Pro, Adobe Audition, BlackMagic Davinci Resolve 15, 7zip, etc.) In allen Tests erreichte die CPU-Package-Temperatur maximal 85°C.

Somit war hier meine erste Feststellung, dass eine Core i9-9900K durchaus mit einem vernünftigen Luftkühler auch unter hoher Last betrieben werden kann. Mit einer potenten Wasserkühlung könnte man hier selbstredend mehr Takt und mehr Leistung auf Dauer herausholen. Allerdings ist dies nichts, was man im Alltag zwingend benötigt, außer in wenigen Ausnahmeszenarien. Doch dann sollte man ohnehin auf eine andere Systemplattform (Xeon, etc.) wechseln.

Den Hitzkopf bändigen

Hohe Temperaturen sind auf Dauer nicht gut für Halbleiter, auch nicht für die CPU. Jeder muss für sich selbst entscheiden, ob er diese Leistung benötigt. Gerade die Flexibilität in der Taktung lässt einem hier viele Optionen. Die von mir ermittelte maximale Leistungsgrenze die ich mit dem EKL Brocken 3 zu kühlen vermag stellt mein Maximum dar, allerdings benötige ich diese Leistung nicht kontinuierlich. Wenn überhaupt, dann nur in Ausnahmesituationen.

Für Standardanwendungen wird ein so hoher Takt ohnehin nicht benötigt. Der Webbrowser oder die Textverarbeitung haben hier keine sehr hohen Ansprüche. Sogar die Grafikbearbeitung unter Photoshop fordert dies nicht ein. Hilfreich kann hier gelegentlich sein, dass man einzelne Kerne kurzzeitig (dynamisch) hochtakten kann. Ob das dann aber 5,1 GHz oder mehr sein müssen bezweifle ich. Insgesamt läuft das System in Idle-Betrieb und unter leitcher Last auch in der obigen Konfiguration gut und ruhig. Allerdings belastet es die CPU und auch die Spannungswandler auf Dauer. Auch wenn es vielleicht nicht zwingend nötig ist, so halte ich dennoch eine moderate Taktung für gesünder. Daher entschied ich, das gemessene Maxiumum etwas zu reduzieren. Zudem wollte ich den Stromverbrauch mildern, denn das bisherige Profil gönnte sich auch unter kleiner Last noch immer 50-60 Watt (nur die CPU). Mein gesamtes System lag somit bei knapp 80 Watt mittlerem Verbrauch.

Zwei Profile

Die Möglichkeit per Gigabyte EasyTune-Software verschiedene Profile zu nutzen und diese im laufenden Betrieb flexibel zu wechseln bot an, zwei Profile zu erstellen. Ein Basisprofil und ein Leistungsprofil. Somit konnte ich die Alltagssituation energiesparend und Komponentenschonend gestalten, während ich für die Leistungshungrigen Renderings im Video- und 3D-Bereich die CPU hochtakte.

Aus dieser Überlegung entstanden zwei Profile:

Profil 1 (Alltag, Energiesparend)

- Alle Kerne 3,6 GHz fixed

Profil 2 (Hochleistung)

- 1-2 Kerne 5,0 GHz

- 3-4 Kerne 4,9 GHz

- 5-6 Kerne 4,8 GHz

- 7-8 Kerne 4,7 GHz

In beiden Profilen sind die restlichen Parameter im UEFI auf Auto gestellt, was bei mir gut funktioniert.

Der Vorteil des Energiesparenden Profil 1 ist, dass die CPU nun im Idle-Betrieb nur noch 10 Watt benötigt, während es keine spürbaren Geschwindigkeitseinbußen gibt. Alle Standardanwendungen laufen tadellos und flink. Das Gesamtsystem benötigt dann nur noch rund 40 Watt, also etwa die Hälfte dessen, was ich vorher gemessen hatte. Das schont nicht nur CPU und Mainboard, sondern auf den Geldbeutel und die Umwelt.

Bei Auslastung aller 8 Kerne in Profil 2 taktet die CPU auf 4,7 GHz (respektive 4,6 GHz bei AVX-Nutzung). Die CPU erwärmt sich im Schnitt auf 80°C (bei 20°C Umgebungstemperatur), was meines Erachtens kein Problem darstellt. Die Leistung ist vollkommen ausreichend für alles, was ich von der Maschine erwarte. Die Lautstärke der Lüfter bleibt hierbei angenehm erträglich, wenn auch hörbar.

Einige Benchmarkwerte

Um einen Vergleich zwischen verschiedenen Systemkonfigurationen zu haben greift man meist auf standardisierte Benchmarks zurück. Diese sind üblicherweise synthetisch, bieten jedoch einen guten Leistungsvergleich. Ich habe verschiedene Benchmarkprogramme verwendet und unter der höchstmöglichen CPU-Taktung (entspricht dem maximalen Profil mit einer dynamischen Taktung von 4,8-5,1 GHz) getestet. So spiegeln die Werte den für mein System höchstmöglichen Wert wieder.

Gesamtgrafikperformance

- 3DMark Time Spy 1.0: 9.230 Punkte

CPU-Performance

- Cinebench R20: Multicore 5009 Punkte

SSD-Performance (CrystalDiskMark 3.0.3 x64)

- M.2 NVMe SSD 500 GByte:

- Sequentiell: Read 2045 MB/s, Write 2026 MB/s

- 512K: Read 1438 MB/s, Write 1389 MB/s

- 4K: Read 27,22 MB/s, Write 101 MB/s

- 4K QD32: Read 496,3 MB/s, Write 398,2 MB/s

- SATA RAID1 SSD 1 TByte:

- Sequentiell: Read 1102 MB/s, Write 487 MB/s

- 512K: Read 675 MB/s, Write 472 MB/s

- 4K: Read 24,05 MB/s, Write 62,05 MB/s

- 4K QD32: Read 420,9 MB/s, Write 350 MB/s

Fazit

Es bleibt Luft nach Oben, in diesem Fall vielleicht auch Wasser. Grundsätzlich zeigt sich, dass es kein Problem ist eine Intel Core i9-9900K mit einem Luftkühler zu betreiben, das System kühl zu halten und es auch energieeffizient zu betreiben. Beachten muss man lediglich, dass man die CPU im Takt (besser der Gesamtleistung) entsprechend situationsbedingt limitiert. Das ist kein Problem, denn die abrufbare Rechenleistung dieses Achtkerners ist ohnehin beeindruckend (Stand 2019 versteht sich).

Im Alltag bleibt es gleichgültig ob man alle Kerne auf energiesparenden 3,6 GHz oder auf voll ausgebauten 5 GHz auf allen Kernen betreibt, zumindest was Standardanwendungen wie Office-Anwendungen und weniger Leistungshungrige Programme betrifft. Auch die meisten Spiele laufen auf geringem Takt problemlos. Fraglos gibt es hier individuelle Unterschiede, das muss man je nach Anwendung selbst herausfinden. 95% der Zeit bleibt die CPU bei mir auf 3,6 GHz. Lediglich beim Rendern von Filmen, 3D-Szenen und Animationen schalte ich auf Turbo-Taktung – wenn es darum geht Zeit zu sparen. Je ambitionierter die Anwendung desto höher die Anforderungen.

Das System besteht jedoch nicht nur aus einer CPU und einem Kühlsystem. Auch die verbauten SSDs leisten gute Arbeit. Der Zugriff auf Videomaterial über die Videoschnittsoftware läuft sehr geschmeidig. Ich konnte hierbei einen minimalen Unterschied zwischen den SATA-SSDs im RAID 1 Verbund und der einzelnen PCIe-SSD auf dem M.2-Platz feststellen. Da ich primär mit Full-HD-Material arbeite und noch keine tieferen Tests mit UHD/4k-Material gesammelt habe, kann ich nur vermuten, dass man dann einen stärkeren Unterschied zwischen den beiden Speichersystemen spüren kann.

Die Grafikkarte konnte ich bisher auch nur mit synthetischen Benchmarks richtig ausreizen. Da ich nicht viele Spiele spiele und ohnehin bisher keines besitze das wirklich alles von solch einer Grafikkarte abverlangt, kann ich für mich nur feststellen, dass alles perfekt in höchster Auflösung läuft. Höchste Auflösung bedeutet bei mir Displaybedingt 1920 x 1200 Pixel. Mich reizt nun, ein der Grafikkarte „angemessenes“ Spiel zu testen, mal schauen ob ich das nicht mal mache.

Das System zu planen, zu bauen und damit zu „spielen“ war – wie man so sagt – ein großer Spaß. Als technikaffiner Mensch bereitet mir das viel Freude. Ich habe nun ein äußerst leistungsfähiges System zur Verfügung das mir – hoffentlich – über die nächsten 8-10 Jahre genügen wird. Derzeit muss ich jedoch feststellen, dass ich mit dem neuen System weit mehr Leistung zur Verfügung habe, als ich tatsächlich benötige. Weniger CPU und GPU hätten definitiv genügt, hätte aber weniger Spaß gemacht. Ich bin daher mit meiner Entscheidung und dem ambitionierten finanziellen Rahmen im reinen.

Es haben sich zum Kaufzeitpunkt zahlreiche Spielregeln und Bedingungen im Vergleich zu den Jahren zuvor teils deutlich geändert. Nicht nur dass die CPUs immer mehr Kerne besitzen und faszinierende Leistung liefern, auch die Art wie wir Daten speichern, welche Bandbreite die Anschlüsse besitzen und dass wir inzwischen sehr potente externe Datenschnittstellen zur Verfügung haben, sind nur einige der großen Veränderungen. Die Kapazitäten der SSDs sind heute ausreichend hoch und die Preise im Rahmen des bezahlbaren, sodass klassische HDDs nur noch dann zum Einsatz kommen sollten, wenn es um große Archive und riesige Datenmengen geht. Für den „Heimanwender“ halte ich eine SSD ohnehin schon länger für die beste Wahl.

Jeder der sich ein System selbst zusammenstellt sollte sich bewusst machen, dass die korrekte Planung nicht einfach daraus besteht, teure und leistungsfähige Komponenten zusammenzuwürfeln. Das Bewusstsein über die Art der Verwendung eines Systems, das Wissen über die Möglichkeiten der Plattformen (sprich CPU, Chipsätze, RAM, Speicher, etc.) sind hierbei unerlässlich um ein rundes und optimales Ergebnis zu erhalten. Wichtig ist hier immer auch der Blick Richtung Verfügbarkeit von PCIe-Lanes, RAM-Konfiguration und Aufbau des Mainboards. Hier lauern durchaus Fallen die es zu vermeiden gilt. Ob es dann ein Luftkühler oder Wasserkühler wird, ob letzteres eine AIO- oder eine Custom-Lösung wird, das hängt primär vom Wunsch des Anwenders ab. Bei den potenten Vielkernern sollte auch besonders auf die Spannungswandler des Mainboards und deren Kühlung geachtet werden. Es ist zugegebenermaßen nicht einfach, so viele Details zu verstehen und im Blick zu behalten. Alles bietet Chancen, Vor- und Nachteile und eben auch Irrtümer. Wer sich nicht intensiv mit der jeweils aktuellen Technologie beschäftigt, der läuft Gefahr sich zu verkaufen. „Viel hilft viel“ ist nicht immer richtig und „Teuer ist immer besser“ bleibt ebenso oft nur eine Phrase. Sachverstand und eine gesunde Einschätzung helfen durchaus, für die eingesetzten Geldmittel ein Maximum an Freude zu erhalten.